Ostrość zdjęć w fotografii cyfrowej - mity i fakty

Jacek Kardasiewicz

Temat ostrości zdjęć nieustannie powraca. Autorzy zdjęć krajobrazu dostają komentarze w stylu "....ładne, ale nieostre....". Gdzie indziej dyskutuje się o ostrości obiektywów, o "mydle" na zdjęciach, ale sensownych wniosków jakoś nie widać. Opisałem już wcześniej dwa zagadnienia związane z wykonywaniem zdjęć aparatem cyfrowym. TU było o tym, co rejestruje matryca podczas wykonywania zdjęć z dużej odległości, a TU było o tym, w jaki sposób matryca i oprogramowanie "rozmywają" rejestrowany obraz. Spróbuję zebrać te wszystkie informacje i w formie rysunków oraz zdjęć unaocznić, czego można spodziewać się po każdym aparacie z matrycą cyfrową.

|

Przyjmijmy, że będziemy próbowali wykonać zdjęcie jasnoszarej cienkiej linii na czarnym tle. Z tekstów przytoczonych wyżej wynika, że ta linia zostanie zarejestrowana przez matrycą mniej więcej w taki sposób: |

|

Zielona krzywa obrazuje rozkład wartości składowych koloru rejestrowanych przez sensory matrycy. W

pobliżu osi wzorcowej linii wartości składowych koloru będą największe, a im dalej od tej osi, wartości te będą coraz mniejsze i w końcu zanikną zupełnie

- przejdą w czarne tło. Matryce aparatów cyfrowych mają różne charakterystyki, aparaty mają różne filtry i oprogramowanie, dlatego nie

będę przywiązywał się do konkretnej ilości sensorów, czy pikseli, które taka wzorcową linię będą rejestrowały. Chodzi tu jedynie o charakter tego, co

taka wirtualna matryca może zarejestrować.

Na podstawie jednej wzorcowej linii ciężko jest mówić o ostrości obrazu. O wiele łatwiej oceniać ostrość, jeśli tych linii będzie więcej, na przykład

będzie to plansza testowa do badania rozdzielczości obiektywów. Tu przyjmę, że na zdjęciu znajdą się cztery równoległe linie, o charakterystyce obrazu

rejestrowanego przez matrycę zgodnej z powyższym rysunkiem. Zasymuluję (z pewnymi niewielkimi uproszczeniami) proces rejestracji obrazu złożonego z

czterech równoległych jasnoszarych linii na czarnym tle, przy różnych odległościach tego obrazu od obiektywu. Krzywe zielone będą symbolizowały

sposób rejestracji poszczególnych linii wzorcowych przez matrycę w idealnych warunkach, a krzywe granatowe będą symbolizowały (z niewielkimi

uproszczeniami) to, co rzeczywiście matryca zarejestruje.

Na tym rysunku wyraźnie widać, że jeśli linie będą od siebie znacznie oddalone, to uzyskamy wierne odwzorowanie rejestrowanego obrazu. Wszystkie

cztery linie będą widoczne i wszystkie będą ostre. Szare linie poziome mają ułatwić ocenę wartości mikro kontrastu, który jest odbierany jako wskaźnik

ostrości zdjęcia. W tym przypadku mikro kontrast, czyli różnica pomiędzy wartością największą i najmniejszą wyniesie 5 działek i będzie największy z

możliwych.

Kolejny rysunek przedstawia ten sam obraz, ale rejestrowany z większej odległości (albo obiektywem o odpowiednio mniejszej ogniskowej). Efektem

takiego oddalenia będzie odpowiednie powiększenie kadru, a tym samym pozorne zbliżenie naszych linii do siebie. Wyraźnie widzimy, że obrazy

poszczególnych linii rejestrowane przez matrycę zaczną na siebie wpływać, pomimo, że w oryginale wszystkie cztery linie będą bez najmniejszych

problemów rozróżniane. Matryca zarejestruje również cztery linie, ale mikro kontrast pomiędzy tymi liniami będzie już nieco mniejszy i będzie miał

wartość 3,5 działki. Dla obserwatora będzie to skutkowało wrażeniem nieznacznego zmniejszenia ostrości obrazu, ale ta ostrość jeszcze będzie

akceptowalna, choć już nie idealna.

Jeśli jeszcze bardziej zwiększymy odległość fotografowanego obiektu od obiektywu, to linie pozornie jeszcze bardziej się przybliżą. W rzeczywistym

obrazie nadal będą rozróżnialne, ale na zdjęciu już nie do końca. Wyraźnie widać, że mikro kontrast pomiędzy liniami zmniejszył się do 1,5 działki,

czyli jest o 70% mniejszy od tego, czego oczekujemy. Jeśli zmniejszył się mikro kontrast, to również zmniejszyła się ostrość naszego obrazu. Taki

obraz zapewne zostanie określony jako "mydło". Po uważnym wpatrzeniu się w zdjęcie dostrzeżemy ślady naszych czterech wzorcowych linii, ale będą one

kompletnie nieostre.

Jeśli odległość obiektu od aparatu będziemy zwiększali nadal uzyskamy jeszcze inny efekt. Nasze cztery linie dadzą na matrycy obraz odpowiadający

jednej, w miarę jednolitej, grubej linii. Patrząc na takie zdjęcie zauważymy, że zdjęcie znów zrobiło się ostre, bo mikro kontrast, który

zarejestruje nasz wzrok znów wyniesie 5 działek. Będzie tylko jedna różnica - zarejestrujemy jedną grubą linię, zamiast czterech cienkich. Należy

pamiętać, że mówimy tu cały czas o obrazach odpowiadających cropowi 100%. Nie będziemy więc w stanie policzyć tych linii na zdjęciu wykonanym z

rozdzielczością 300dpi, czy nawet 80dpi (jak dla monitora). Pozostanie jedynie wrażenie, że obraz jest ostry lub jest rozmazany, czyli nieostry. A

co się stanie jeśli takie obrazy wyostrzymy w programie graficznym? Wrażenie ostrości obrazów 1 i 4 się pogłębi, ale wrażenie "mydłowatości" obrazu 3

zapewne jeszcze wzrośnie.

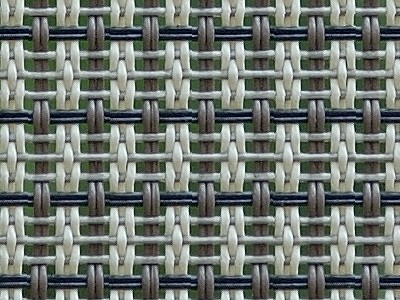

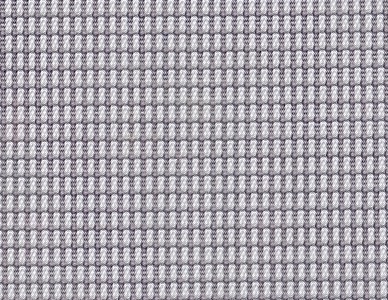

Można powiedzieć, że to tylko schematyczne rysunki zawierające pewne uproszczenia. Jak więc sprawa będzie wyglądała na zdjęciach? Aby to

zaprezentować zrobiłem kilka zdjęć siatki o dość złożonym splocie i module poziomym równym 6 milimetrów. Wszystkie zdjęcia były robione za pomocą

lustrzanki Nikon D200 z obiektywem Nikkor AF-S 70-200 VR przy ogniskowej 200mm. Zdjęcia były robione z odległości około: 2, 5, 10, 15, 20, 25 i 30

metrów. Dalsze zwiększanie odległości nie miało już sensu, bo i tak na zdjęciach nie było widać faktury oryginału, a jedynie szarą plamę. Wszystkie

poniższe zdjęcia to cropy 100%. Dla lepszej oceny tego co zdjęcia przedstawiają proponuję powiększanie obrazów do 200%, 300%, 400%. Przy

takich powiększeniach można dokładnie zaobserwować to, co rzeczywiście zarejestrowała matryca.

Zdjęcie pierwsze (zrobione z odległości około 2 metrów) przedstawia oryginalną fakturę (splot) fotografowanej siatki. Widoczne są wszystkie

szczegóły splotu, a także zielony kolor tła za siatką.

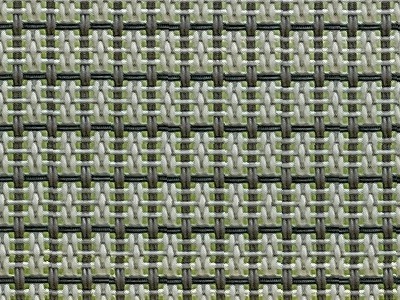

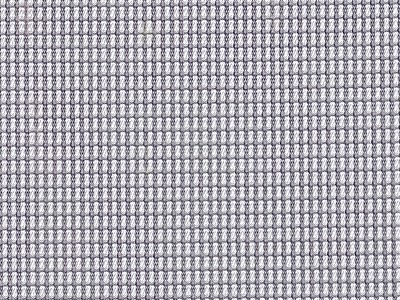

To zdjęcie wykonane zostało z odległości około 5 metrów. Nadal widać na nim oryginalny splot siatki. Można uznać że zdjęcie jest ostre i prawidłowo

odwzorowuje oryginał.

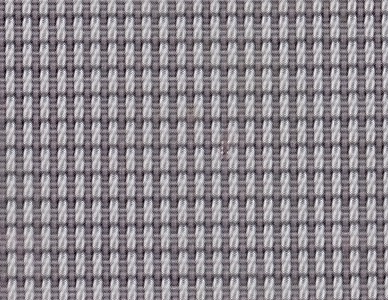

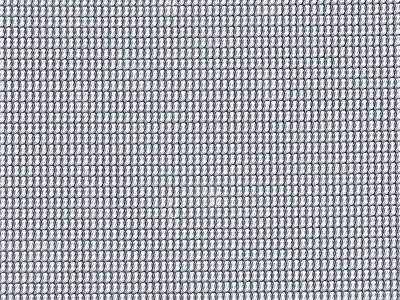

Na zdjęciu robionym z odległości około 10 metrów faktura siatki zaczyna się zmieniać, a zdjęcie wygląda na niezbyt ostre. W istotony sposób zmieniła się

również kolorystyka zdjęcia. Przez porównanie tego zdjęcia z pierwszym, można się jeszcze doszukać podobieństwa, ale nieco na siłę. Jeśli ktoś nie

widział oryginału, z tego zdjęcia już go raczej nie odtworzy. Warto zwrócić uwagę na to, że zdjęcie było robione z odległości 10 metrów obiektywem o

ogniskowej 200 milimetrów, obiekt ma moduł (wielkość) 6 milimetrów, a na zdjęciu nie widać już istotnych szczegółów tego obiektu. Czy to wina

kiepskiego obiektywu? Na pewno nie. Czy to wina kiepskiego body? Na pewno nie. Jest to wina cyfrowej fotografii jako takiej.

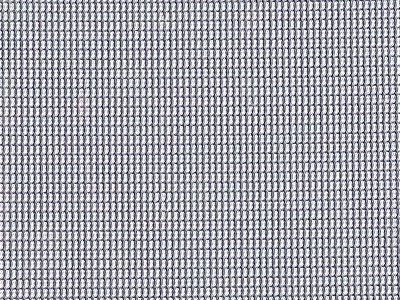

Ale zobaczmy, co matryca zarejestruje z odległości 15 metrów. No cóż, zarejestrowała zupełnie inna siatkę i to w jeszcze innym kolorze. Tu nie da

się już doszukać podobieństwa z oryginałem, nawet po znacznym powiększeniu

Zdjęcie zrobione z odległości 20 metrów zarejestrowało podobny wzór siatki, ale sprawia wrażenie jakby nieco ostrzejszego

Z odległości 25 metrów praktycznie nie widzimy już niczego, co mogłoby wskazywać na podobieństwo do oryginalnej siatki.

To zdjęcie zrobiono z odległości 30 metrów. Wydaje się, że jest ono stosunkowo ostre, pomimo że utrata szczegółów jest bardzo, bardzo duża.

Zdjęcia robione z dalszych odległości, na przykład 50 metrów, będą sprawiały wrażenie, że żadna siatka na nich nie istnieje, a fotografowana jest jedynie

prawie jednolita szara powierzchnia na oparciu ostro zarejestrowanego krzesła ogrodowego.

Jakie z tego wnioski?

Pierwsze spostrzeżenie musi dotyczyć tego, że jest bardzo duża różnica pomiędzy ostrym obrazem, który wiernie oddaje szczegóły rzeczywistego

obiektu, a pozornie ostrym obrazem, który nie odpowiada oryginałowi. Te prawidłowo odwzorowane i ostre zdjęcia to zazwyczaj makro oraz portrety i

reporterka wykonywane z niewielkiej odległości.

Drugie spostrzeżenie, dotyczy zależności ostrości obrazu od ostrości obiektywu. O ostrości obiektywu możemy mówić tylko wtedy, gdy zarejestrowany

obraz dokładnie odpowiada oryginałowi. Jeśli tak nie jest, to ostrość obiektywu nie ma żadnego związku z ostrością zdjęcia, a pozorna ostrość

zdjęcia jest jedynie wynikiem "interferencji" obrazu z siatką sensorów matrycy i wyostrzenia go w programie graficznym

Można jeszcze wyciągnąć trzeci wniosek. Coś co wygląda na ostre na zdjęciu nie musi istnieć w rzeczywistości, a może

być jedynie wirtualnym wytworem algorytmu przetwarzania obrazu przez optykę obiektywu, filtry AA, matrycę i oprogramowanie aparatu. Nasuwa się jeszcze

takie pytanie. Czy możliwe jest, aby ostre było coś, co nie odpowiada oryginałowi, coś co w rzeczywistości nie istnieje? Czy ta pozorna ostrość

zdjęcia nie wynika jedynie z wyostrzenia w programie graficznym?

Na koniec jeszcze kilka uwag, o tym, gdzie takie problemy będą się objawiać najczęściej. Oczywiście są to zdjęcia obiektów o drobnej, jednolitej,

regularnej fakturze, na przykład zdjęcia różnych siatek, firanek, ale również zdjęcia zwierząt (sierść układa się zazwyczaj w takie właśnie

regularne drobne wzory), czy zdjęcia ptaków (pióra i ich elementy składowe, również tworzą dość regularne drobne wzory). Są to wszystko obiekty, które

podczas fotografowania, mogą powodować niekorzystną "interferencję" z siatką matrycy, czyli mogą tworzyć obrazy nie istniejące w rzeczywistości. A tak na

marginesie, mora z D70 jest również wytworem takiej "interferencji" obrazu z siatką sensorów cyfrowej matrycy. Różnica jest tylko taka, że względu na

różne filtry AA, w D70 "interferencja" dotyczy pojedynczych sensorów rejestrujących kolory, a w D200 całych pikseli, a co za tym idzie, jest dużo

mniej widoczna na zdjęciach.

Zaprezentowane tu zjawiska dotyczą wszystkich aparatów cyfrowych (lustrzanki, kompakty, hybrydy), wszystkich stosowanych obiektywów

(szerokokątne, standardowe, teleobiektywy bez względu na to, czy to zoomy, czy obiektywy stałoogniskowe) i wszystkich fotografowanych obiektów. Przy

nieszczęśliwie dobranej odległości od konkretnego obiektu, każdy taki zestaw może dać nieostre i zniekształcone zdjęcie. Może również dać zniekształcone

zdjęcie, które po wyostrzeniu będzie sprawiało wrażenie ostrego (na przykład wszystkie zdjęcia rozległego krajobrazu), pomimo że przedstawia coś zupełnie

innego, niż oryginalny fotografowany obiekt, postać, czy krajobraz.

Powrót do Technics